常规LoRA微调千亿模型的成本高达数百万,这让高校、中小型实验室、初创公司甚至个人研发者难以参与。而趋境科技KTransformers与LLaMA-Factory的深度集成,彻底转变了这一现状,为大模型微调给予了低成本、高效率的新挑选。

该方案支撑顾客应用 LoRA 等轻量级微调方法,在极少量 GPU 资产下完成模型定制。经实测,仅占用约 41GB 显存,协作 2T 内存,就能达成 46.55 token/s 的微调吞吐量。关于研发者而言,操作流程也十分简便:只需与此同时安装KTransformers与LLaMA-Factory环境,配置好Kimi-K2的yaml文件并运行,即可开启微调任务。更关键的是,这是目前在花费级显卡上达成微调超大参数MoE模型的唯一可行方案。

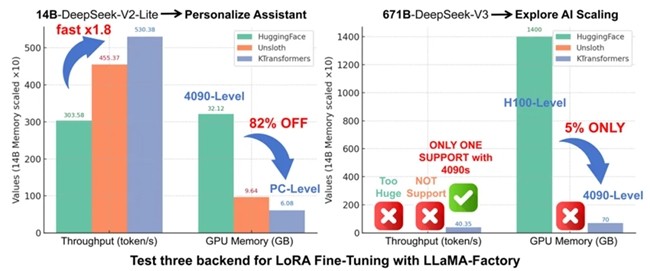

在性能对比测试中,KTransformers微调方案长处显著。在较小规模的MoE模型(DeepSeek-14B)测试中,其吞吐速率超出常规方案1.8倍,显存占用较常规方案减少 82%。常规方案多依赖H100等高端 GPU,而KTransformers可支撑4090级花费级显卡,大幅减少了硬件门槛。这一方案让革新门槛显著减少,学术研发领域能尝试更多样化的念头,公司应用层面可针对自身需求迅速微调出定制化模型,且成本和周期大幅缩减,产品迭代更灵活高效